- LLM を用いた生成 AI : ChatGPT, Claude, and Llama

- Google Generative AI : Gemini, Imagen, and Gemma

- 画像生成AI: DALL・E 3 and Stable Diffusion

- ローカル PC で日本語 LLM の運用:Llama.cpp

- ローカル PC で日本語 LLM の運用:Ollama

- ローカル PC で日本語 LLM の運用:LangChain

- Transformers で日本語 LLM の運用

- Visual Studio Code GitHub Copilot

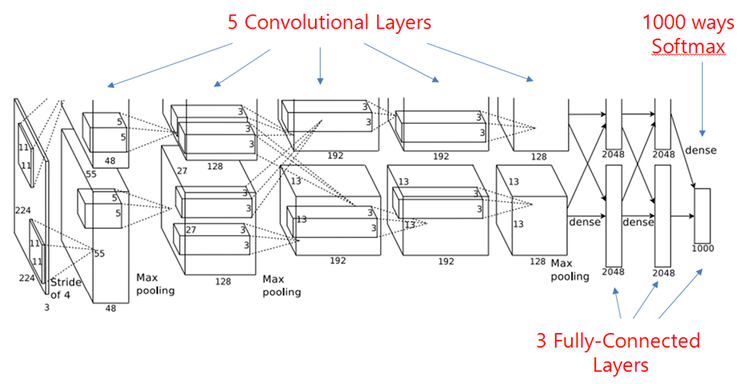

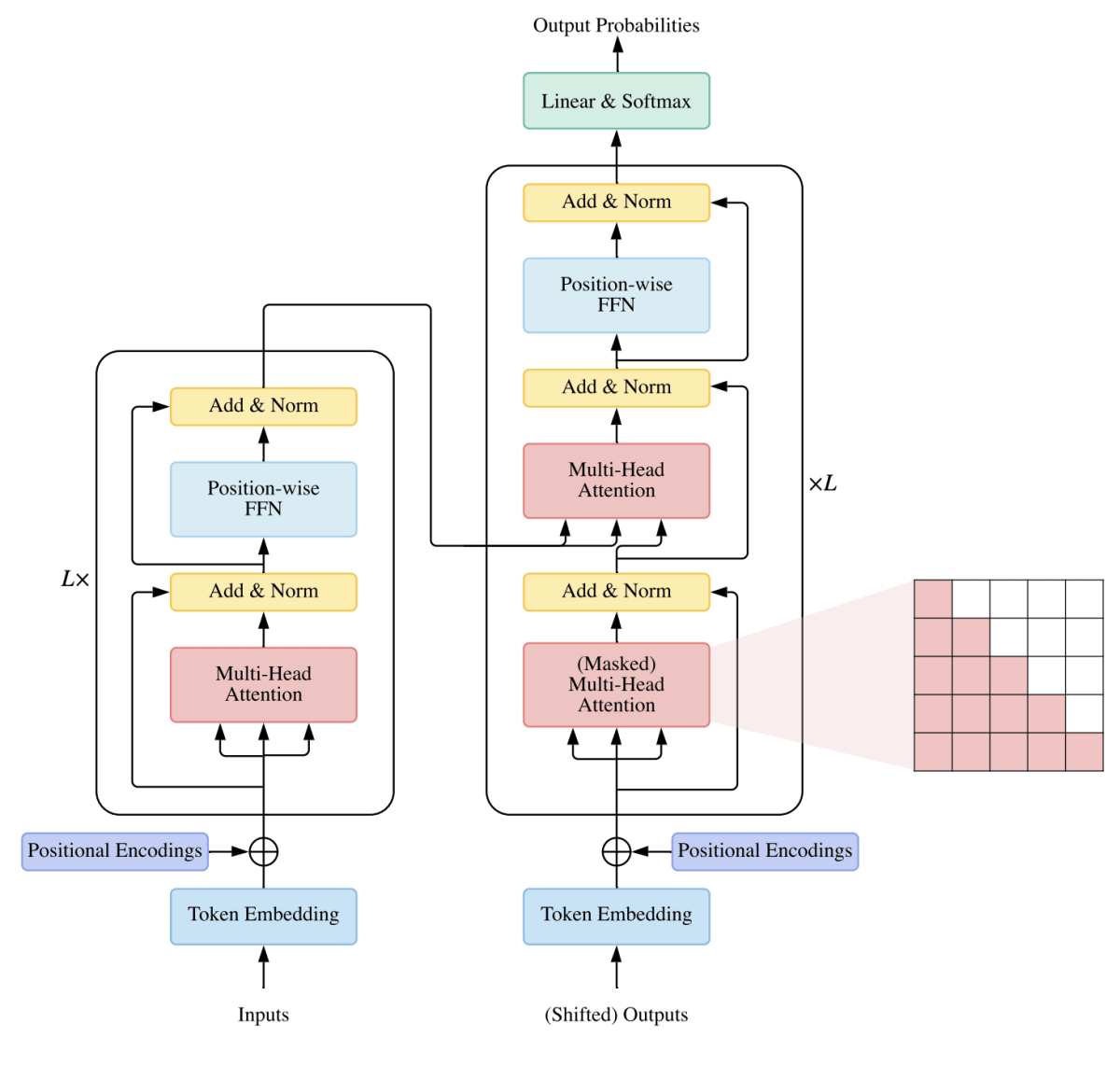

2022年11月に OpenAI 社が ChatGPT という大規模言語処理モデル(LLM)を採用した生成的人工知能のチャットボットを発表して以来、ChatGPT をはじめとする生成的人工知能(generative AI)が多くの民間企業のみならず政府機関や地方自治体においても活用されています。GPT とは Generative Pretrained Transfomer の略で、その名前の通り、Transformer と呼ばれる言語処理モデルを改良したものです。 ChatGPT は GPT の最新版を組み込んだチャットボットです。最近では、Googleは、テキスト、画像、オーディオを越えて機能する新しい大規模なマルチモーダルモデル(LMM)であるGeminiを発表しました。また、Meta 社は LlaMA 3 と呼ばれる大規模言語モデルをリリースしました。さらには、OpenAI で ChatGPT の開発に従事していたメンバーによって設立されたAnthropic社が Claude 3 という生成的AIを開発しました。LLM や LMM を組み込んだ生成的AI開発の黎明期に突入しています。さらに、AI Agent と呼ばれる新たな利用方法(ユーザーに代わり、与えられた目標を達成するために、AIを用いて自律的に判断・行動するソフトウエアシステム)が発展しています。

日本国内でも、近年、無料で利用できる日本語大規模言語モデルが多数開発されています。海外モデル(Llama 2 ,3 、 Mistral や GPTなど)に日本語で追加事前学習を行ったモデルの代表的なものは、Llama-3.1-70B-Japanese-Instruct-2407、 Llama 3 Swallow 、llama-3-youko-70b-instructなどです。 フルスクラッチで事前学習した日本語LLMモデルには、stockmark/stockmark-100b-instruct-v0.1 、Tanuki-8x8B-dpo-v1.0 、cyberagent/Llama-3.1-70B-Japanese-Instruct-2407などがあります。これらのLLMには、MIT や Apache-2.0 といったオープンソースライセンスが適用されています。

ChatGPT、 Claude、 Gemini などの基本モデルは、使用回数の制限はありますが、無料で利用することができます。各モデルの利用にはアカウント登録が必要です。当然のことながら、最上位モデルを利用回数などの制限無しに利用するためには、有料となります。現在、これらの生成AIモデルを利用するために、各モデルの公式アプリを携帯電話にインストールことができます。Microsoft の Copilot もアプリを提供しています。それぞれに使用回数や使用可能 LLM などの制限はありますが、基本的な機能を手軽に無料で、PCのブラウザや携帯電話から生成 AI モデルを利用することが出来るようになっています。

OpenAI API、Anthropi API や Gemini API を利用すれば、PC から ChatGPT や Google Cloud などにアクセスして 高性能の LLM を利用することは可能ですが、専用サーバーにアクセスするため有料であり、原則として、汎用モデルを利用することになり、各ユーザーごとに差別化したモデルは使用できません。近年、Meta -llama を初めとして、Google の Gemma 、DeepSeek 、Alibaba(Qwen) などのオープンソースのモデルが提供され始めました。20025年8月に、OpenAI も GPT_oss モデルを発表しました。

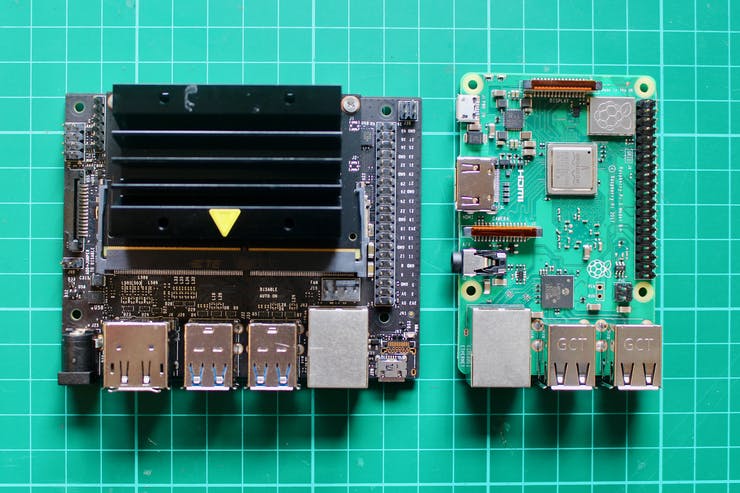

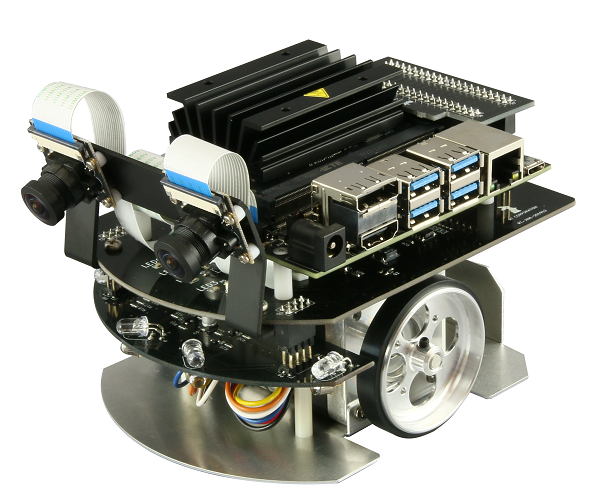

こうした進展から、ChatGPT や Claude などの上位モデルと同じ能力を持つ大規模言語モデル(LLM)を各ユーザーのPCやオンプレミス・サーバーなどのローカル環境で動かすローカル LLM の構築が可能になってきました。クラウド環境ではなく、各自のコンピュータシステムにモデルのソースデータをダウンロードして追加学習して利用することができます。クラウド環境と異なり利用料を気にせず、プライバシーやセキュリティを確保しながら、各自のニーズに合わせたカスタマイズが可能です。パラメータ数が数十億個以下のモデルは CPU のみのノートPCでも利用できるようですが、高度なLLMをローカルで利用するためには相応の GPU や CPU などの計算リソースが必要になります。他方、LangChain や llama.cpp を利用して量子化モデルを作成できれば、エッジデバイスでも LLM の構築が可能です。 HuggingFace には、GGUF 形式の量子化モデルを含むオープンソースのモデルが多数提供されています。GPU を搭載していない軽量な PC やエッジデバイスでも LLM を構築して、運用できるようになりました。これらのモデルは小規模言語モデル(Small Langauge Model; SLM)と呼ばれることがあります。

なお、各種生成 AI モデル間の競争と開発スピードは非常に速いので、最新のモデルに関する情報については、適宜、当該モデルの公式サイトを参照ください。

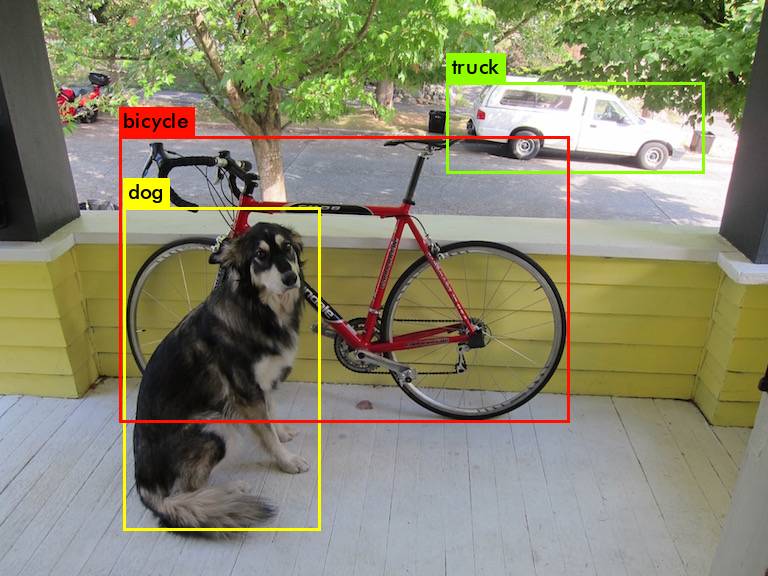

Google ImageFX による画像生成の例